Introduzione sul Machine Learning

Negli ultimi anni, il Machine Learning (ML) è diventato uno dei temi più discussi nel mondo della tecnologia e non solo. Dalle raccomandazioni personalizzate di Netflix e Spotify, fino ai sistemi di guida autonoma, il Machine Learning è ovunque, anche se spesso non ce ne rendiamo conto. Ma cosa significa davvero questo termine e perché è così rivoluzionario?

Il Machine Learning, o apprendimento automatico, è una branca dell’Intelligenza Artificiale (AI) che permette ai computer di imparare dai dati e migliorare le loro prestazioni senza essere esplicitamente programmati. In altre parole, anziché seguire istruzioni rigide scritte da un programmatore, le macchine sviluppano la capacità di riconoscere schemi e prendere decisioni in autonomia, affinando le proprie risposte man mano che ricevono nuove informazioni.

Machine Learning vs Intelligenza Artificiale vs Deep Learning

Spesso, i termini Machine Learning, Intelligenza Artificiale e Deep Learning vengono usati in modo intercambiabile, ma hanno significati distinti:

- Intelligenza Artificiale (AI) è il concetto più ampio e si riferisce a qualsiasi sistema o tecnologia che simula capacità cognitive umane, come il ragionamento o la risoluzione di problemi.

- Machine Learning (ML) è una sotto-disciplina dell’AI che si basa sull’idea che i computer possano imparare dai dati per eseguire compiti specifici senza programmazioni dettagliate.

- Deep Learning (DL) è una forma avanzata di ML che utilizza reti neurali artificiali per analizzare enormi quantità di dati e prendere decisioni più complesse, spesso con un livello di precisione superiore.

Immagina l’AI come un grande contenitore, all’interno del quale il Machine Learning è una delle principali tecniche, mentre il Deep Learning è una specializzazione avanzata di quest’ultimo.

Perché il Machine Learning è così importante?

L’importanza del Machine Learning è legata alla sua capacità di automatizzare processi, migliorare l’efficienza e generare previsioni accurate in un’ampia gamma di settori. Oggi, aziende di ogni dimensione utilizzano il ML per ottimizzare il servizio clienti, individuare frodi, migliorare l’esperienza utente e prendere decisioni basate sui dati.

Ad esempio:

- Nel settore medico, il ML aiuta a diagnosticare malattie analizzando immagini radiologiche o dati genetici.

- Nella finanza, gli algoritmi di ML prevedono le fluttuazioni del mercato e rilevano attività sospette per prevenire frodi.

- Nel marketing digitale, il ML è il motore che permette di offrire pubblicità mirate e contenuti personalizzati in base agli interessi degli utenti.

Breve storia del Machine Learning

Anche se può sembrare una tecnologia recente, il concetto di Machine Learning ha radici che risalgono agli anni ‘50. Alcuni dei momenti chiave nella sua evoluzione includono:

- 1956: John McCarthy conia il termine “Intelligenza Artificiale”.

- 1959: Arthur Samuel introduce il concetto di “apprendimento automatico” sviluppando un programma in grado di giocare a dama migliorando nel tempo.

- Anni ‘80-‘90: Vengono sviluppati i primi modelli di reti neurali e le tecniche di apprendimento basate su alberi decisionali.

- Anni 2000: Con l’aumento della potenza di calcolo e la disponibilità di dati, il Machine Learning diventa una tecnologia alla base di molti sistemi moderni.

- Oggi: L’uso del ML è esploso grazie alla combinazione di Big Data, cloud computing e intelligenza artificiale avanzata.

Questo è solo l’inizio di un viaggio nel mondo del Machine Learning. Nei prossimi capitoli, esploreremo più a fondo il funzionamento di questi sistemi, i principali algoritmi e le loro applicazioni nella vita reale.

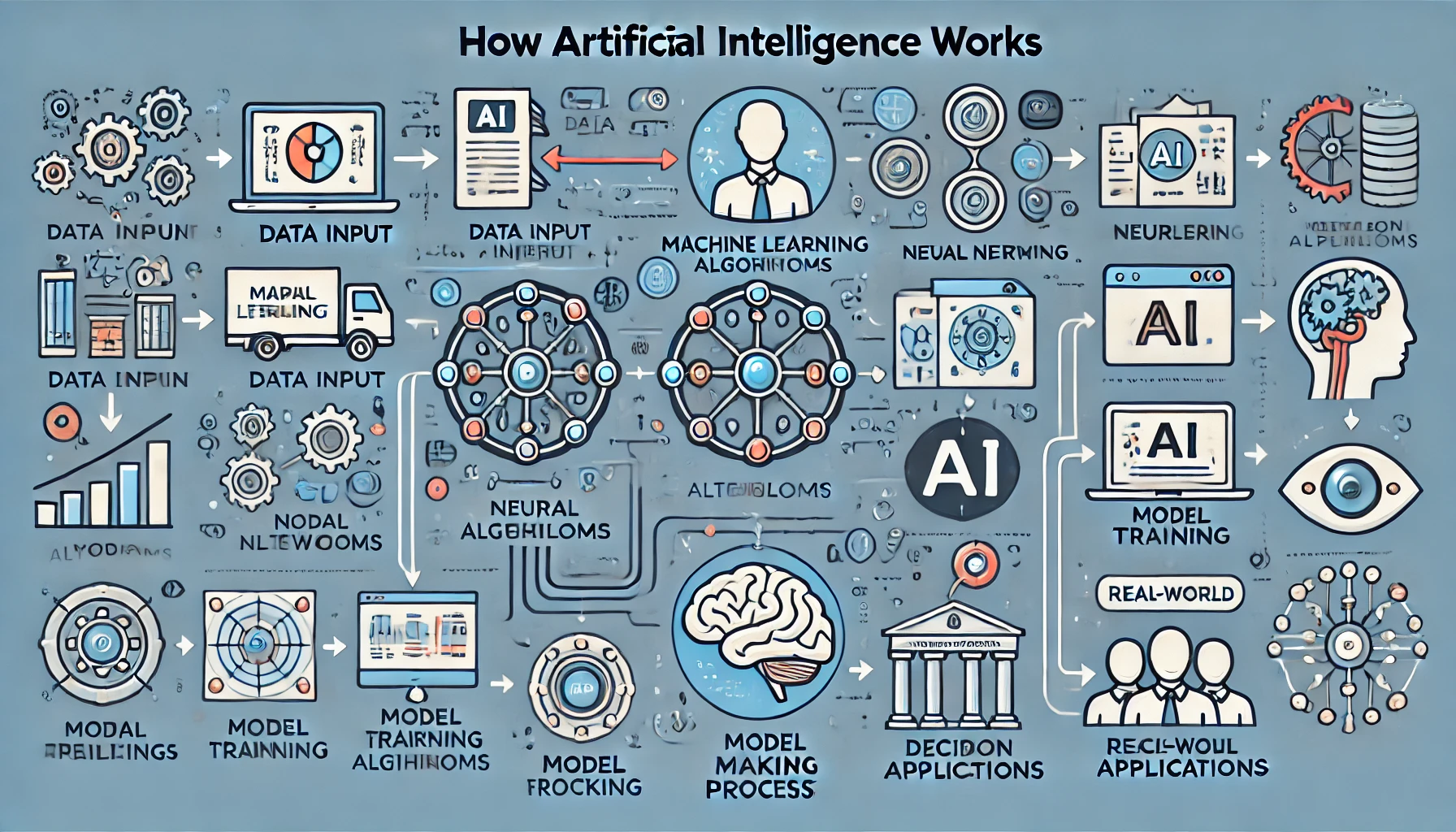

Come Funziona il Machine Learning

Il Machine Learning si basa su un principio semplice ma rivoluzionario: i computer possono imparare dai dati senza bisogno di istruzioni dettagliate per ogni possibile situazione. Ma come avviene questo apprendimento? Per capirlo, immaginiamo un bambino che impara a riconoscere gli animali. Inizialmente, gli vengono mostrate immagini di gatti e cani con la relativa etichetta. Dopo aver visto abbastanza esempi, il bambino è in grado di distinguere un gatto da un cane anche senza aiuti. Questo è lo stesso principio che guida il Machine Learning: i modelli analizzano grandi quantità di dati, identificano schemi e migliorano le loro previsioni nel tempo.

I Pilastri del Machine Learning

Per comprendere il funzionamento del Machine Learning, è utile conoscere tre concetti fondamentali: dati, algoritmi e modelli.

-

Dati: Il carburante del Machine Learning

Tutti i sistemi di Machine Learning hanno bisogno di dati per imparare. Senza dati, non ci sarebbe nulla da analizzare e nessun modo per migliorare le previsioni. I dati possono essere di vario tipo:

- Strutturati: come tabelle di database, file CSV o fogli di calcolo.

- Non strutturati: come immagini, video, testi o suoni.

La qualità e la quantità dei dati sono essenziali per ottenere risultati affidabili. Se i dati sono incompleti, sbilanciati o imprecisi, il modello potrebbe imparare nel modo sbagliato e fare errori.

-

Algoritmi: Il cervello del Machine Learning

Gli algoritmi sono le istruzioni che permettono al computer di trovare schemi nei dati. Esistono diversi tipi di algoritmi, ognuno con caratteristiche specifiche, ma tutti condividono un obiettivo comune: ottimizzare le previsioni e ridurre l’errore.

-

Modelli: Il risultato dell’apprendimento

Un modello di Machine Learning è ciò che viene creato dopo l’addestramento su un set di dati. Più dati un modello analizza, più diventa preciso nelle sue previsioni. Tuttavia, c’è sempre un equilibrio da trovare tra generalizzazione e specializzazione. Se un modello si adatta troppo ai dati di addestramento (overfitting), potrebbe non funzionare bene con dati nuovi.

Tipologie di Apprendimento nel Machine Learning

Il modo in cui una macchina impara dipende dalla strategia utilizzata. Le principali categorie di apprendimento sono tre:

-

Apprendimento Supervisionato

L’apprendimento supervisionato è il metodo più comune ed è simile all’esempio del bambino che impara a riconoscere gli animali. Un modello viene addestrato su un insieme di dati etichettati, dove ogni input è associato a una risposta corretta.

Esempi pratici:

- Un sistema che analizza email e decide se sono spam o non spam.

- Un’app di riconoscimento vocale che associa le onde sonore alle parole corrispondenti.

Gli algoritmi più comuni per l’apprendimento supervisionato includono regressione lineare, alberi decisionali e reti neurali artificiali.

-

Apprendimento Non Supervisionato

In questo caso, il modello non riceve dati etichettati ma deve scoprire autonomamente schemi nei dati. È come dare a un bambino un mazzo di carte senza spiegargli le regole del gioco: dovrà trovare delle somiglianze tra le carte per capire come raggrupparle.

Esempi pratici:

- Segmentazione dei clienti in base ai comportamenti d’acquisto.

- Algoritmi di raccomandazione che suggeriscono film o prodotti in base alle preferenze dell’utente.

Gli algoritmi più utilizzati in questo ambito sono K-Means Clustering e PCA (Analisi delle Componenti Principali).

-

Apprendimento per Rinforzo

Questa tecnica si ispira al modo in cui impariamo dalle esperienze. Un agente (cioè il sistema) interagisce con un ambiente e riceve ricompense o penalità in base alle sue azioni, migliorando nel tempo.

Esempi pratici:

- I programmi di intelligenza artificiale che imparano a giocare ai videogiochi.

- I sistemi di guida autonoma che ottimizzano le decisioni di guida.

Uno degli algoritmi più noti per l’apprendimento per rinforzo è il Q-Learning.

Il Processo di Addestramento di un Modello di Machine Learning

L’addestramento di un modello di Machine Learning segue un processo ben definito:

- Raccolta dei dati – I dati vengono raccolti e preparati.

- Pulizia e Preprocessing – I dati vengono analizzati e ripuliti da errori o informazioni inutili.

- Scelta dell’algoritmo – Si seleziona il metodo più adatto per il problema da risolvere.

- Addestramento del modello – Il modello analizza i dati e apprende dagli esempi.

- Validazione e Test – Il modello viene testato con dati nuovi per verificare la sua accuratezza.

- Messa in produzione – Se il modello è efficace, viene utilizzato in un’applicazione reale.

Grazie a queste fasi, il Machine Learning sta diventando sempre più preciso e potente, permettendo alle macchine di prendere decisioni complesse con sempre maggiore affidabilità.

Algoritmi Principali del Machine Learning

Gli algoritmi sono il cuore del Machine Learning. Sono loro a trasformare i dati grezzi in modelli capaci di riconoscere schemi e fare previsioni. A seconda del tipo di apprendimento (supervisionato, non supervisionato o per rinforzo), esistono diversi algoritmi, ognuno con i propri punti di forza e limiti.

Vediamo quelli più importanti e come vengono utilizzati nella pratica.

Algoritmi di Apprendimento Supervisionato

L’apprendimento supervisionato si basa su dati etichettati: ogni esempio ha una risposta corretta, e il modello impara a collegare gli input agli output.

-

Regressione Lineare e Logistica

La regressione lineare viene usata per fare previsioni su valori numerici. Ad esempio, se si vuole stimare il prezzo di un appartamento in base alla metratura, la regressione lineare trova una relazione tra queste variabili e prevede il prezzo di una casa nuova in base ai dati passati.

La regressione logistica è simile alla regressione lineare, ma viene usata per problemi di classificazione binaria, ad esempio per prevedere se un cliente comprerà un prodotto o meno.

Alcuni esempi di applicazione includono la previsione dei prezzi degli immobili, il rilevamento di frodi nelle carte di credito e la diagnosi medica basata su sintomi.

-

Alberi di Decisione e Random Forest

Gli alberi di decisione sono strutture ad albero che prendono decisioni basate su condizioni. Un modello potrebbe, ad esempio, decidere se concedere un prestito a un cliente analizzando fattori come il reddito, il livello di indebitamento e la cronologia dei pagamenti.

La Random Forest è un insieme di alberi di decisione che lavorano insieme per migliorare l’accuratezza e ridurre il rischio di errori.

Questi algoritmi vengono usati nei filtri antispam, nella diagnosi di malattie basate su sintomi e nella classificazione dei clienti per le strategie di marketing.

-

Support Vector Machines (SVM)

Le Support Vector Machines separano i dati in categorie utilizzando una linea o un piano se lo spazio è tridimensionale. Sono particolarmente utili nei problemi di classificazione complessi.

Questi algoritmi vengono spesso impiegati nel riconoscimento facciale e nella classificazione di testi, come ad esempio distinguere articoli di sport da quelli di politica.

-

Reti Neurali Artificiali

Le reti neurali sono modelli ispirati al funzionamento del cervello umano. Sono composte da neuroni artificiali che elaborano i dati in più strati: input, nascosti e output. Più strati ci sono, più la rete è potente.

Vengono utilizzate per il riconoscimento vocale nei dispositivi di assistenza virtuale, nella traduzione automatica e nella generazione di immagini realistiche.

Algoritmi di Apprendimento Non Supervisionato

Nell’apprendimento non supervisionato, il modello esplora i dati senza sapere in anticipo quali siano le risposte giuste. È utile per scoprire strutture nascoste nei dati.

-

Clustering (K-Means, DBSCAN)

K-Means divide i dati in gruppi omogenei basati su similarità. Ad esempio, un e-commerce può usarlo per segmentare i clienti in base ai loro comportamenti d’acquisto.

DBSCAN è più flessibile rispetto a K-Means e viene usato per individuare gruppi con forme irregolari e per rilevare anomalie nei dati.

Questi algoritmi trovano applicazione nella segmentazione dei clienti per strategie di marketing, nel rilevamento di frodi bancarie e nel raggruppamento di documenti simili.

-

PCA (Analisi delle Componenti Principali)

La PCA riduce la dimensionalità dei dati eliminando le informazioni meno importanti. È utile quando si lavora con dataset molto grandi e si vuole semplificare l’analisi.

Viene spesso utilizzata nella compressione di immagini e nell’analisi di dati finanziari.

Algoritmi di Apprendimento per Rinforzo

L’apprendimento per rinforzo è basato su un sistema di ricompense e penalità: il modello prende decisioni, valuta il risultato e migliora le proprie strategie nel tempo.

Q-Learning e Deep Q Networks (DQN)

Il Q-Learning è un metodo che aiuta un agente, come un robot, a scegliere le azioni migliori per ottenere una ricompensa massima.

Le Deep Q Networks rappresentano una versione avanzata del Q-Learning che utilizza reti neurali profonde per gestire situazioni complesse.

Questi algoritmi vengono impiegati nell’automazione industriale e robotica, nel trading finanziario e nei videogiochi con intelligenza artificiale avanzata.

Quale Algoritmo Scegliere?

Non esiste un algoritmo migliore in assoluto: la scelta dipende dal tipo di problema da risolvere.

- Se si devono fare previsioni numeriche, la regressione lineare è una buona scelta.

- Per problemi di classificazione, gli alberi di decisione o le Support Vector Machines possono essere efficaci.

- Se l’obiettivo è segmentare i clienti o individuare anomalie nei dati, il clustering è una soluzione adatta.

- Per compiti complessi come il riconoscimento immagini, le reti neurali sono la scelta migliore.

- In ambienti dinamici che richiedono decisioni continue, l’apprendimento per rinforzo è la tecnica più adatta.

Strumenti e Librerie per il Machine Learning

Il Machine Learning non sarebbe così diffuso senza gli strumenti e le librerie che semplificano lo sviluppo e l’addestramento dei modelli. Grazie a questi strumenti, anche chi non è un esperto programmatore può sperimentare con algoritmi avanzati e applicare il Machine Learning a problemi reali.

In questo capitolo vedremo i linguaggi di programmazione più utilizzati, le principali librerie per il Machine Learning e le piattaforme cloud che permettono di scalare i modelli su grandi quantità di dati.

Linguaggi di Programmazione per il Machine Learning

Sebbene esistano diversi linguaggi di programmazione utilizzati nel Machine Learning, due sono quelli più diffusi:

-

Python

Python è il linguaggio più popolare per il Machine Learning grazie alla sua semplicità e alla vasta disponibilità di librerie. È facile da imparare e ha un’enorme comunità di sviluppatori che contribuiscono con nuove soluzioni e aggiornamenti.

Alcuni motivi per cui Python è così diffuso nel Machine Learning:

- Sintassi semplice e leggibile

- Ampio ecosistema di librerie e framework

- Forte integrazione con strumenti di data science

-

R

R è un linguaggio particolarmente usato nel settore accademico e nella statistica. È molto potente per l’analisi dei dati e la visualizzazione, ma meno diffuso rispetto a Python nel mondo aziendale.

R viene spesso scelto per analisi statistiche approfondite, data mining e modellazione predittiva, ma ha una curva di apprendimento più ripida rispetto a Python.

Librerie e Framework per il Machine Learning

Le librerie di Machine Learning contengono implementazioni pronte all’uso di algoritmi e strumenti per la gestione dei dati. Le più utilizzate sono le seguenti.

-

Scikit-learn

Scikit-learn è una delle librerie più famose per il Machine Learning in Python. Fornisce strumenti per la classificazione, la regressione, il clustering e la riduzione della dimensionalità.

Caratteristiche principali:

- Implementazione di algoritmi standard come regressione, SVM, alberi decisionali

- Ottimizzazione dell’iperparametri e validazione dei modelli

- Compatibilità con librerie come NumPy e Pandas

Scikit-learn è ideale per chi vuole sviluppare modelli semplici e veloci senza dover gestire complessità avanzate come le reti neurali.

-

TensorFlow

TensorFlow, sviluppato da Google, è una delle piattaforme più potenti per il Deep Learning. Permette di costruire e addestrare reti neurali artificiali, oltre a gestire modelli su larga scala.

Vantaggi principali:

- Supporto per CPU, GPU e TPU (per calcoli più veloci)

- Ampia flessibilità nella creazione di reti neurali personalizzate

- Libreria Keras integrata per una programmazione più intuitiva

TensorFlow è ampiamente usato in settori come la visione artificiale, il riconoscimento vocale e la traduzione automatica.

-

PyTorch

PyTorch, sviluppato da Facebook, è un’alternativa a TensorFlow con un approccio più intuitivo e dinamico. È particolarmente apprezzato nella ricerca accademica grazie alla sua facilità di debug e alla gestione efficiente delle reti neurali.

Punti di forza:

- Maggiore flessibilità rispetto a TensorFlow

- Debug più semplice grazie all’esecuzione dinamica

- Forte integrazione con le librerie di deep learning

Negli ultimi anni, PyTorch ha guadagnato molta popolarità e viene spesso scelto per la ricerca e lo sviluppo di nuove architetture di rete neurale.

-

Keras

Keras è una libreria ad alto livello che semplifica la creazione di reti neurali. In realtà, Keras è un’interfaccia per TensorFlow, che permette di definire e addestrare modelli con poche righe di codice.

È particolarmente utile per chi vuole sperimentare con il Deep Learning senza dover affrontare la complessità di TensorFlow.

-

XGBoost

XGBoost è una libreria ottimizzata per problemi di classificazione e regressione basata su gradient boosting. È molto veloce ed efficiente ed è spesso usata nelle competizioni di Machine Learning.

Punti di forza:

- Prestazioni elevate su dataset di grandi dimensioni

- Capacità di gestire dati mancanti e prevenire l’overfitting

- Utilizzato in competizioni come Kaggle

Piattaforme Cloud per il Machine Learning

Se si lavora con grandi quantità di dati o si ha bisogno di potenza di calcolo elevata, l’utilizzo di piattaforme cloud può essere la soluzione migliore.

-

Google AI Platform

Google offre una piattaforma cloud che permette di addestrare modelli di Machine Learning su larga scala. Dispone di strumenti come AutoML, che consente di creare modelli senza una profonda conoscenza tecnica.

-

AWS Machine Learning

Amazon Web Services (AWS) offre strumenti per il Machine Learning che permettono di addestrare, distribuire e scalare modelli in modo efficiente. SageMaker, in particolare, è uno dei servizi più utilizzati per sviluppare applicazioni basate sull’intelligenza artificiale.

-

Microsoft Azure Machine Learning

Azure fornisce un ambiente per la creazione, l’addestramento e la gestione dei modelli di Machine Learning con un’interfaccia intuitiva e supporto per Python e R.

Quale Strumento Scegliere?

La scelta della libreria o piattaforma dipende dagli obiettivi e dal livello di esperienza dell’utente.

- Se si vuole iniziare con modelli semplici, Scikit-learn è una scelta eccellente.

- Per il Deep Learning, TensorFlow e PyTorch sono le opzioni più valide.

- Se l’obiettivo è la scalabilità e l’integrazione con altri servizi cloud, Google AI, AWS o Azure possono essere le soluzioni migliori.

Le librerie e gli strumenti per il Machine Learning continuano a evolversi, rendendo sempre più accessibile questa tecnologia.

Applicazioni Pratiche del Machine Learning

Il Machine Learning non è solo un concetto teorico o una tecnologia riservata agli esperti di intelligenza artificiale. Oggi è presente in molti aspetti della nostra vita quotidiana, spesso senza che ce ne accorgiamo. Dalla personalizzazione dei contenuti sui social media ai sistemi di guida autonoma, passando per la diagnostica medica e la finanza, il Machine Learning sta rivoluzionando numerosi settori.

In questo capitolo esploreremo le applicazioni più importanti di questa tecnologia e come viene utilizzata per risolvere problemi concreti.

Machine Learning nel Business e nel Marketing

Uno dei settori in cui il Machine Learning ha avuto il maggiore impatto è il marketing digitale. Le aziende sfruttano questa tecnologia per analizzare il comportamento dei clienti, prevedere le tendenze di mercato e personalizzare l’esperienza d’acquisto.

- Analisi predittiva: Le piattaforme di e-commerce utilizzano modelli di Machine Learning per prevedere quali prodotti potrebbero interessare a un cliente in base ai suoi acquisti precedenti e alle abitudini di navigazione.

- Personalizzazione dell’esperienza utente: Algoritmi di raccomandazione, come quelli di Netflix o Amazon, suggeriscono film, serie TV o prodotti basandosi sulle preferenze dell’utente.

- Automazione delle campagne pubblicitarie: I sistemi di advertising, come quelli di Google e Facebook, usano il Machine Learning per ottimizzare gli annunci e mostrarli agli utenti più interessati, migliorando il ritorno sull’investimento.

Grazie a questi strumenti, le aziende possono migliorare il coinvolgimento dei clienti e aumentare le vendite con strategie basate sui dati.

Machine Learning nella Sanità

Il settore sanitario è uno dei più beneficiati dall’intelligenza artificiale e dal Machine Learning. La capacità di analizzare enormi quantità di dati in tempi ridotti permette di migliorare la diagnostica, personalizzare i trattamenti e ottimizzare le risorse ospedaliere.

- Diagnosi assistita da AI: I modelli di Machine Learning possono analizzare immagini mediche, come radiografie e risonanze magnetiche, per individuare tumori, fratture o altre anomalie con un livello di accuratezza spesso superiore a quello umano.

- Sviluppo di farmaci: L’analisi predittiva aiuta a identificare le molecole più promettenti per nuovi farmaci, accelerando i tempi di ricerca e riducendo i costi di sviluppo.

- Monitoraggio dei pazienti: Dispositivi indossabili, come smartwatch e sensori biometrici, raccolgono dati in tempo reale e possono segnalare anomalie che indicano problemi di salute, consentendo interventi tempestivi.

L’uso del Machine Learning in ambito medico sta migliorando l’efficienza del settore sanitario e contribuendo a salvare vite umane.

Machine Learning nella Finanza e negli Investimenti

Le istituzioni finanziarie sfruttano il Machine Learning per automatizzare processi, ridurre i rischi e migliorare le decisioni di investimento.

- Trading algoritmico: Gli hedge fund e le banche utilizzano algoritmi che analizzano i mercati finanziari in tempo reale per prendere decisioni di investimento basate su dati storici e tendenze.

- Prevenzione delle frodi: I sistemi di sicurezza bancari monitorano le transazioni e rilevano comportamenti sospetti, come pagamenti insoliti o accessi da località non usuali, bloccando potenziali frodi.

- Analisi del credito: Gli algoritmi analizzano i dati finanziari di un cliente per determinare il suo livello di rischio e decidere se concedere un prestito o una carta di credito.

L’introduzione del Machine Learning nel settore finanziario ha reso le transazioni più sicure ed efficienti, migliorando la gestione del rischio.

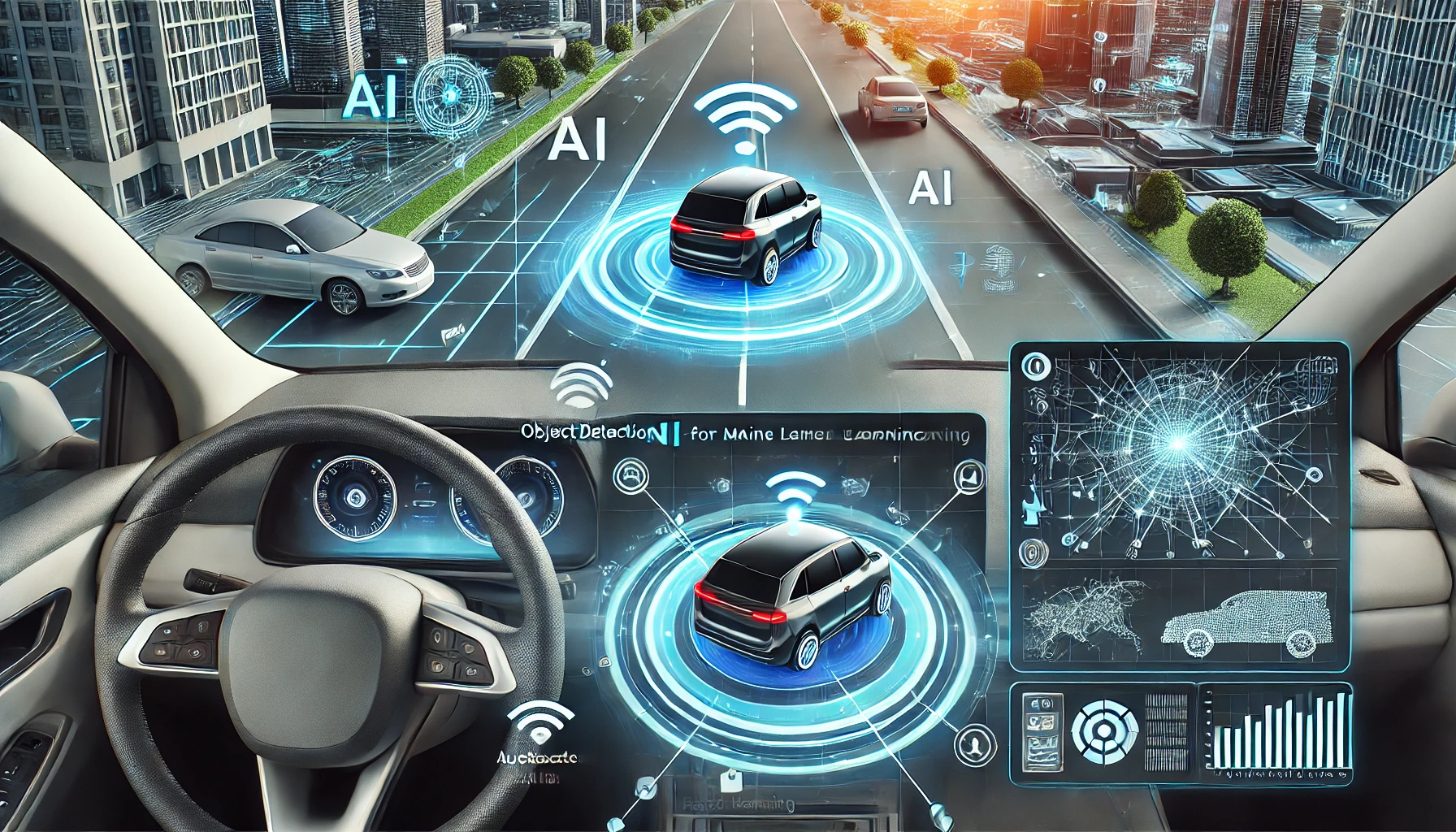

Machine Learning nell’Industria Automobilistica

Le case automobilistiche stanno investendo sempre di più nel Machine Learning per sviluppare veicoli autonomi e migliorare la sicurezza stradale.

- Guida autonoma: Le auto a guida autonoma, come quelle di Tesla, utilizzano reti neurali per elaborare le immagini delle telecamere e prendere decisioni in tempo reale. Il sistema è in grado di riconoscere pedoni, segnali stradali e altri veicoli per evitare incidenti.

- Manutenzione predittiva: I sensori installati nei veicoli monitorano il funzionamento di motore, freni e altri componenti, segnalando eventuali problemi prima che si verifichino guasti.

- Assistenza alla guida: Funzioni come il controllo adattivo della velocità, il mantenimento della corsia e il parcheggio automatico si basano su algoritmi di Machine Learning per migliorare la sicurezza e il comfort di guida.

Il futuro dell’industria automobilistica sarà sempre più orientato verso l’automazione, con veicoli in grado di prendere decisioni intelligenti per ridurre gli incidenti e migliorare l’efficienza del trasporto.

Machine Learning nella Cybersecurity

Con l’aumento delle minacce informatiche, il Machine Learning è diventato uno strumento essenziale per migliorare la sicurezza digitale.

- Rilevamento delle minacce: Gli algoritmi di Machine Learning analizzano il traffico di rete e individuano attività anomale che potrebbero indicare un attacco informatico.

- Protezione dagli attacchi phishing: I sistemi di sicurezza usano modelli di apprendimento per identificare email fraudolente prima che raggiungano la casella di posta dell’utente.

- Autenticazione avanzata: Il riconoscimento facciale e le impronte digitali utilizzano reti neurali per migliorare la sicurezza degli accessi ai dispositivi e ai servizi online.

L’intelligenza artificiale sta diventando un alleato fondamentale nella lotta contro il cybercrimine, rendendo le reti e i sistemi informatici più sicuri.

Il Ruolo del Machine Learning nel Futuro

Il Machine Learning sta già trasformando molti settori, ma il suo potenziale è ancora lontano dall’essere completamente esplorato. Con l’aumento della potenza di calcolo e la disponibilità di dati sempre più dettagliati, le applicazioni diventeranno ancora più sofisticate.

Alcuni degli sviluppi futuri più promettenti includono:

- L’intelligenza artificiale spiegabile (Explainable AI – XAI), che renderà più trasparenti le decisioni prese dagli algoritmi.

- L’integrazione tra Machine Learning e Internet of Things (IoT), con dispositivi sempre più intelligenti in grado di interagire tra loro.

- L’uso del Quantum Machine Learning, che potrebbe rivoluzionare la velocità e l’efficienza degli algoritmi.

Le applicazioni del Machine Learning continueranno a crescere, offrendo soluzioni innovative per migliorare la qualità della vita e l’efficienza dei sistemi che utilizziamo ogni giorno.

Sfide e Limitazioni del Machine Learning

Nonostante i suoi enormi progressi e il crescente utilizzo in numerosi settori, il Machine Learning non è una tecnologia priva di problemi. Affinché possa essere adottato in modo efficace e responsabile, è necessario comprendere le sfide e le limitazioni che ne accompagnano lo sviluppo e l’applicazione.

Alcuni degli ostacoli principali riguardano la qualità e la disponibilità dei dati, la complessità computazionale, i rischi legati ai bias e alle implicazioni etiche. In questo capitolo analizzeremo le difficoltà più significative e le possibili soluzioni.

-

Qualità e Quantità dei Dati

Il Machine Learning si basa sui dati per imparare e prendere decisioni. Tuttavia, affinché un modello funzioni correttamente, è necessario che i dati siano di buona qualità, sufficientemente numerosi e rappresentativi del fenomeno che si vuole analizzare.

Problemi legati ai dati

- Dati insufficienti: Se il dataset è troppo piccolo, il modello potrebbe non essere in grado di generalizzare correttamente e rischierebbe di fornire previsioni inaccurate.

- Dati rumorosi o errati: Se il dataset contiene errori, informazioni ridondanti o inconsistenze, l’algoritmo potrebbe apprendere schemi sbagliati.

- Dati sbilanciati: Se alcune categorie sono sovrarappresentate rispetto ad altre, il modello potrebbe sviluppare una visione distorta della realtà, ignorando le classi meno frequenti.

Possibili soluzioni

- Raccolta e pulizia dei dati: È fondamentale garantire che i dati siano ben organizzati, corretti e privi di duplicati.

- Aumento dei dati (data augmentation): Tecniche come la creazione di nuovi dati sintetici possono aiutare a migliorare la rappresentatività di un dataset.

- Bilanciamento delle classi: Quando alcune categorie sono sottorappresentate, si possono utilizzare tecniche come l’oversampling o l’undersampling per riequilibrare i dati.

-

Overfitting e Generalizzazione

Uno dei problemi più comuni nel Machine Learning è l’overfitting, che si verifica quando un modello impara troppo bene i dettagli del dataset di addestramento, adattandosi eccessivamente ai dati anziché generalizzare correttamente.

L’overfitting può portare a prestazioni eccellenti su dati conosciuti ma scarse su dati nuovi, rendendo il modello poco utile nel mondo reale.

Come prevenire l’overfitting

- Utilizzo di un dataset di test: Suddividere i dati in un set di addestramento e un set di test aiuta a verificare se il modello è in grado di generalizzare.

- Regolarizzazione: Tecniche come L1 e L2 (Ridge e Lasso) riducono la complessità del modello, evitando che si adatti troppo ai dati specifici.

- Early stopping: Arrestare l’addestramento quando il modello inizia a mostrare segni di overfitting aiuta a ottenere prestazioni più stabili.

-

Bias nei Modelli di Machine Learning

Uno dei problemi più critici del Machine Learning è la presenza di bias nei dati e negli algoritmi. Se i dati di addestramento contengono pregiudizi, il modello può ereditare e amplificare tali distorsioni, portando a decisioni ingiuste o discriminatorie.

Esempi di bias nei modelli

- Bias nei sistemi di selezione del personale: Se un algoritmo viene addestrato su dati storici che favoriscono un determinato genere o gruppo etnico, potrebbe ripetere questi schemi di discriminazione.

- Bias negli algoritmi di riconoscimento facciale: Alcuni studi hanno dimostrato che i modelli di riconoscimento facciale funzionano meglio su alcune etnie rispetto ad altre, con rischi di errori e ingiustizie.

- Bias nei sistemi di credito: Se un modello è addestrato su dati finanziari che penalizzano determinate categorie di persone, potrebbe negare prestiti a gruppi svantaggiati senza una reale giustificazione economica.

Come ridurre il bias nei modelli

- Dati più rappresentativi: Assicurarsi che il dataset sia bilanciato e includa diversi gruppi di popolazione.

- Monitoraggio costante: Analizzare le decisioni del modello per individuare eventuali distorsioni e correggerle tempestivamente.

- AI spiegabile: Tecniche di interpretabilità dei modelli aiutano a capire perché un algoritmo prende determinate decisioni, rendendo più facile individuare ed eliminare i bias.

-

Complessità Computazionale e Costi

L’addestramento di modelli di Machine Learning, in particolare quelli basati su reti neurali profonde, richiede un’enorme quantità di potenza di calcolo. Questo comporta due problemi principali:

- Costi elevati: Le infrastrutture per il training di modelli avanzati richiedono hardware specializzato come GPU e TPU, oltre a costosi servizi cloud.

- Tempi lunghi di addestramento: Alcuni modelli possono richiedere giorni o settimane per essere addestrati correttamente.

Soluzioni per ridurre la complessità computazionale

- Uso di modelli pre-addestrati: Spesso è più efficiente partire da modelli già addestrati su dataset di grandi dimensioni e adattarli a un problema specifico.

- Ottimizzazione degli algoritmi: Tecniche come la quantizzazione e la pruning delle reti neurali riducono il numero di calcoli necessari, migliorando l’efficienza.

- Utilizzo del cloud computing: Servizi come Google AI, AWS e Azure offrono infrastrutture scalabili che permettono di gestire modelli complessi senza dover acquistare hardware costoso.

- Implicazioni Etiche e Privacy

Con l’aumento dell’uso del Machine Learning, emergono importanti questioni etiche e problemi legati alla privacy.

Problemi etici e di privacy

- Utilizzo improprio dei dati: Molte aziende raccolgono e analizzano enormi quantità di dati personali, spesso senza il consenso esplicito degli utenti.

- Sistemi di sorveglianza: L’uso dell’intelligenza artificiale per il riconoscimento facciale e il monitoraggio della popolazione solleva preoccupazioni sulla libertà individuale.

- Decisioni non trasparenti: Se un modello prende decisioni senza spiegare il processo che ha seguito, può essere difficile contestare errori o ingiustizie.

Possibili soluzioni

- Regolamentazioni più severe: Leggi come il GDPR in Europa impongono alle aziende di rispettare la privacy degli utenti e di garantire maggiore trasparenza nell’uso dei dati.

- Sviluppo di AI etica: Le aziende e i ricercatori devono adottare pratiche di sviluppo responsabili, assicurandosi che l’intelligenza artificiale venga usata in modo equo e sicuro.

- Miglioramento dell’interpretabilità: Tecniche come l’Explainable AI (XAI) stanno diventando sempre più importanti per rendere gli algoritmi più comprensibili e affidabili.

Il Machine Learning è una tecnologia potente e rivoluzionaria, ma non è priva di difficoltà. Dalla qualità dei dati ai costi computazionali, dal bias nei modelli ai problemi di privacy, esistono numerose sfide che devono essere affrontate per garantirne un uso corretto ed efficace.

Nei prossimi anni, la ricerca si concentrerà sempre di più su soluzioni per rendere il Machine Learning più trasparente, accessibile e responsabile.

Il Futuro del Machine Learning

Il Machine Learning ha già trasformato profondamente il mondo in cui viviamo, ma il suo potenziale è ancora lontano dall’essere completamente esplorato. Con il continuo sviluppo tecnologico e l’aumento della potenza di calcolo, il futuro del Machine Learning si prospetta ricco di innovazioni che avranno un impatto sempre più profondo sulla società, l’economia e la nostra vita quotidiana.

In questo capitolo analizzeremo le principali tendenze che guideranno l’evoluzione del Machine Learning nei prossimi anni, dalle tecnologie emergenti alle nuove applicazioni, fino alle sfide etiche e regolatorie.

-

L’Intelligenza Artificiale Spiegabile (Explainable AI – XAI)

Uno dei limiti attuali del Machine Learning è la cosiddetta “black box”, ovvero l’incapacità di comprendere il processo decisionale di alcuni algoritmi, soprattutto quelli basati su reti neurali profonde. Questo problema è particolarmente critico in settori come la sanità, la finanza e la giustizia, dove è fondamentale poter spiegare le decisioni prese dai modelli.

L’Explainable AI (XAI) è un campo di ricerca che punta a rendere più trasparenti e interpretabili gli algoritmi di Machine Learning. Le soluzioni che stanno emergendo includono:

- Metodi per visualizzare l’importanza delle variabili nei processi decisionali.

- Tecniche di interpretabilità locale, che spiegano le singole decisioni prese da un modello su un caso specifico.

- Modelli ibridi, che combinano reti neurali con regole più trasparenti per migliorare la comprensibilità.

L’obiettivo è costruire sistemi di intelligenza artificiale che non solo siano precisi ed efficienti, ma anche comprensibili e verificabili dagli esseri umani.

-

Il Quantum Machine Learning (QML)

L’informatica quantistica promette di rivoluzionare molte aree della tecnologia, compreso il Machine Learning. Grazie alla capacità dei computer quantistici di elaborare informazioni in parallelo su una scala impossibile per i computer tradizionali, il Quantum Machine Learning potrebbe accelerare l’addestramento dei modelli e risolvere problemi finora irrisolvibili.

Alcuni vantaggi potenziali del QML includono:

- Maggiore velocità nell’analisi di grandi dataset, riducendo drasticamente i tempi di calcolo.

- Migliore gestione della complessità, con la possibilità di modellare sistemi altamente non lineari.

- Applicazioni avanzate nell’ottimizzazione, con impatti in settori come la finanza, la logistica e la ricerca scientifica.

Sebbene i computer quantistici siano ancora in fase sperimentale, le ricerche in questo campo stanno facendo passi da gigante, e nei prossimi decenni potremmo assistere a una vera rivoluzione nell’uso del Machine Learning.

-

L’integrazione tra Machine Learning e Internet of Things (IoT)

Con l’aumento dei dispositivi connessi, il Machine Learning sta giocando un ruolo sempre più centrale nel mondo dell’Internet of Things (IoT). Sensori intelligenti, dispositivi smart e sistemi automatizzati stanno raccogliendo enormi quantità di dati che possono essere analizzati in tempo reale per migliorare efficienza, sicurezza e automazione.

Le applicazioni dell’integrazione tra Machine Learning e IoT includono:

- Manutenzione predittiva nelle fabbriche e negli impianti industriali, dove i sensori monitorano lo stato delle macchine e prevedono eventuali guasti.

- Domotica avanzata, con sistemi intelligenti in grado di adattarsi alle abitudini degli utenti per ottimizzare consumi energetici e comfort abitativo.

- Gestione delle città intelligenti, con algoritmi che analizzano il traffico, ottimizzano i trasporti pubblici e migliorano la qualità dell’aria.

Questa combinazione tra intelligenza artificiale e dispositivi connessi potrebbe portare a una nuova era di automazione e ottimizzazione dei processi.

-

Machine Learning e Automazione dei Processi Aziendali

Le aziende stanno investendo sempre di più nell’uso del Machine Learning per automatizzare operazioni ripetitive e migliorare la produttività. Questo fenomeno, noto come Intelligent Process Automation (IPA), permette di sostituire attività manuali con sistemi intelligenti in grado di prendere decisioni in autonomia.

Esempi di applicazione dell’IPA includono:

- Chatbot e assistenti virtuali per il customer service, capaci di comprendere il linguaggio naturale e rispondere ai clienti in modo personalizzato.

- Automazione della gestione documentale, con sistemi che analizzano, categorizzano e processano contratti, fatture e report.

- Analisi predittiva nelle risorse umane, con modelli che aiutano a individuare i candidati più adatti per una posizione lavorativa o prevedono il turnover dei dipendenti.

Questa trasformazione sta portando a un cambiamento profondo nei processi aziendali, riducendo i costi operativi e migliorando l’efficienza complessiva.

-

Etica e Regolamentazione dell’Intelligenza Artificiale

Con il crescente utilizzo del Machine Learning in ambiti critici come la sanità, la sicurezza e la giustizia, diventa sempre più urgente affrontare le implicazioni etiche di questa tecnologia.

Alcune delle principali preoccupazioni riguardano:

- Privacy e protezione dei dati, in un’epoca in cui gli algoritmi raccolgono e analizzano enormi quantità di informazioni personali.

- Discriminazione e bias algoritmico, che possono influenzare negativamente le decisioni prese dai modelli di Machine Learning.

- Responsabilità legale, per determinare chi è responsabile in caso di errori o danni causati da un’intelligenza artificiale.

Governi e istituzioni stanno lavorando per definire regolamenti che garantiscano un uso equo e sicuro del Machine Learning. Il Regolamento Europeo sull’Intelligenza Artificiale, ad esempio, mira a stabilire regole chiare per l’uso dell’AI in Europa, imponendo trasparenza e controlli più severi sulle applicazioni più sensibili.

Il Machine Learning è una delle tecnologie più rivoluzionarie del nostro tempo e continuerà a evolversi, portando innovazioni che cambieranno il modo in cui viviamo e lavoriamo.

Dal miglioramento della trasparenza dei modelli all’integrazione con l’informatica quantistica, dall’espansione dell’IoT all’automazione aziendale, il futuro del Machine Learning è ricco di opportunità. Tuttavia, è fondamentale affrontare anche le sfide legate all’etica, alla privacy e alla regolamentazione, per garantire che questa tecnologia venga utilizzata in modo responsabile e a beneficio di tutti.

Nei prossimi anni assisteremo a sviluppi straordinari, che renderanno il Machine Learning ancora più potente, accessibile e presente nella nostra vita quotidiana. Resta solo da vedere fino a che punto questa tecnologia potrà spingersi e quali nuove possibilità aprirà per il futuro.

Conclusione

Il Machine Learning è una tecnologia che ha rivoluzionato il modo in cui interagiamo con il mondo digitale e continuerà a influenzare profondamente la nostra vita nei prossimi anni. Dai motori di raccomandazione che suggeriscono contenuti personalizzati ai sistemi di diagnostica medica basati su intelligenza artificiale, questa disciplina sta trasformando settori chiave come la sanità, la finanza, il marketing e la mobilità.

Abbiamo visto come il Machine Learning si sviluppi attraverso tre principali modalità di apprendimento: supervisionato, non supervisionato e per rinforzo. Abbiamo esplorato i suoi algoritmi più importanti, gli strumenti utilizzati per implementarlo e le applicazioni pratiche che stanno migliorando l’efficienza e l’innovazione in diversi campi. Tuttavia, non mancano le sfide da affrontare, come la qualità dei dati, il rischio di bias, la complessità computazionale e le implicazioni etiche.

Dove ci porterà il Machine Learning?

Il futuro del Machine Learning sarà segnato da alcune tendenze chiave che ne determineranno l’evoluzione:

- Trasparenza e interpretabilità: La necessità di comprendere come un modello prende decisioni diventerà sempre più importante, specialmente in ambiti sensibili come la sanità e la giustizia.

- Machine Learning quantistico: L’integrazione con l’informatica quantistica potrebbe portare a progressi senza precedenti nella velocità e nell’efficienza dei modelli.

- Automazione avanzata: Il Machine Learning sarà sempre più integrato nei processi aziendali e industriali, riducendo il bisogno di intervento umano in molte attività ripetitive.

- Etica e regolamentazione: Governi e istituzioni lavoreranno per garantire un uso equo e responsabile dell’intelligenza artificiale, evitando discriminazioni e violazioni della privacy.

Come prepararsi a un mondo guidato dal Machine Learning?

Se il Machine Learning continuerà a essere un elemento chiave dell’innovazione, diventerà essenziale acquisire competenze in questo settore, sia per chi vuole lavorare nel campo della tecnologia sia per chi desidera comprendere meglio le implicazioni di questa trasformazione. Alcuni passi per avvicinarsi a questa disciplina includono:

- Imparare i fondamenti: Approfondire concetti di statistica, algebra lineare e programmazione (Python è il linguaggio più utilizzato nel settore).

- Sperimentare con librerie e strumenti: Scikit-learn, TensorFlow e PyTorch sono ottimi punti di partenza per chi vuole costruire modelli e testare le potenzialità del Machine Learning.

- Seguire l’evoluzione del settore: Il Machine Learning è un campo in continua evoluzione, quindi è fondamentale restare aggiornati su nuove tecnologie e metodologie.

Conclusione finale

Il Machine Learning non è più una tecnologia del futuro, ma una realtà consolidata che sta cambiando il nostro modo di vivere e lavorare. Con le sue enormi potenzialità e le sue sfide, rappresenta una delle innovazioni più importanti del nostro tempo.

Saperne di più e comprendere il suo funzionamento non è utile solo agli sviluppatori o agli scienziati dei dati, ma a chiunque voglia navigare con consapevolezza in un mondo sempre più dominato dall’intelligenza artificiale. La chiave per il futuro sarà trovare un equilibrio tra innovazione, etica e trasparenza, garantendo che il Machine Learning sia uno strumento di progresso per tutti.

FAQ – Domande Frequenti sul Machine Learning

Ecco alcune delle domande più comuni sul Machine Learning, con risposte chiare e concise per comprendere meglio questa tecnologia.

-

Cos’è il Machine Learning?

Il Machine Learning è una branca dell’intelligenza artificiale che consente ai computer di apprendere dai dati senza essere programmati esplicitamente per ogni attività.

-

Qual è la differenza tra Machine Learning e Intelligenza Artificiale?

L’intelligenza artificiale è un concetto più ampio che comprende tutte le tecnologie che simulano l’intelligenza umana. Il Machine Learning è una delle tecniche usate per realizzare sistemi intelligenti attraverso l’apprendimento dai dati.

-

Quali sono le principali tipologie di Machine Learning?

- Apprendimento supervisionato: Il modello impara da dati etichettati (esempi con risposte corrette).

- Apprendimento non supervisionato: Il modello trova schemi nei dati senza etichette.

- Apprendimento per rinforzo: Il modello migliora le proprie decisioni basandosi su ricompense e penalità.

-

Quali sono i linguaggi di programmazione più usati per il Machine Learning?

Python è il linguaggio più diffuso grazie alle sue librerie dedicate (Scikit-learn, TensorFlow, PyTorch). Anche R è utilizzato per analisi statistiche e modelli predittivi.

-

Quali sono le applicazioni più comuni del Machine Learning?

- Motori di raccomandazione (Netflix, Amazon)

- Diagnosi mediche basate su immagini e dati clinici

- Finanza e trading algoritmico

- Cybersecurity e rilevamento delle frodi

- Veicoli autonomi e assistenza alla guida

-

Il Machine Learning sostituirà il lavoro umano?

Il Machine Learning automatizza molte attività, ma crea anche nuove opportunità lavorative. L’elemento umano rimane fondamentale per supervisionare, interpretare e migliorare i modelli.

-

Quali sono i rischi legati al Machine Learning?

- Bias nei dati, che possono portare a decisioni discriminatorie

- Problemi di privacy e uso improprio dei dati

- Complessità nell’interpretazione delle decisioni dei modelli

-

Come posso iniziare a studiare Machine Learning?

Puoi iniziare con corsi online su piattaforme come Coursera, Udacity o edX, imparando Python e sperimentando con librerie come Scikit-learn e TensorFlow.

-

Quali aziende utilizzano il Machine Learning?

Le principali aziende che investono nel Machine Learning includono Google, Amazon, Microsoft, Tesla, Meta (Facebook) e molte startup nel settore AI.

-

Qual è il futuro del Machine Learning?

Si prevede un’evoluzione verso modelli più interpretabili, integrazione con il quantum computing e maggiore automazione nei processi aziendali e industriali.