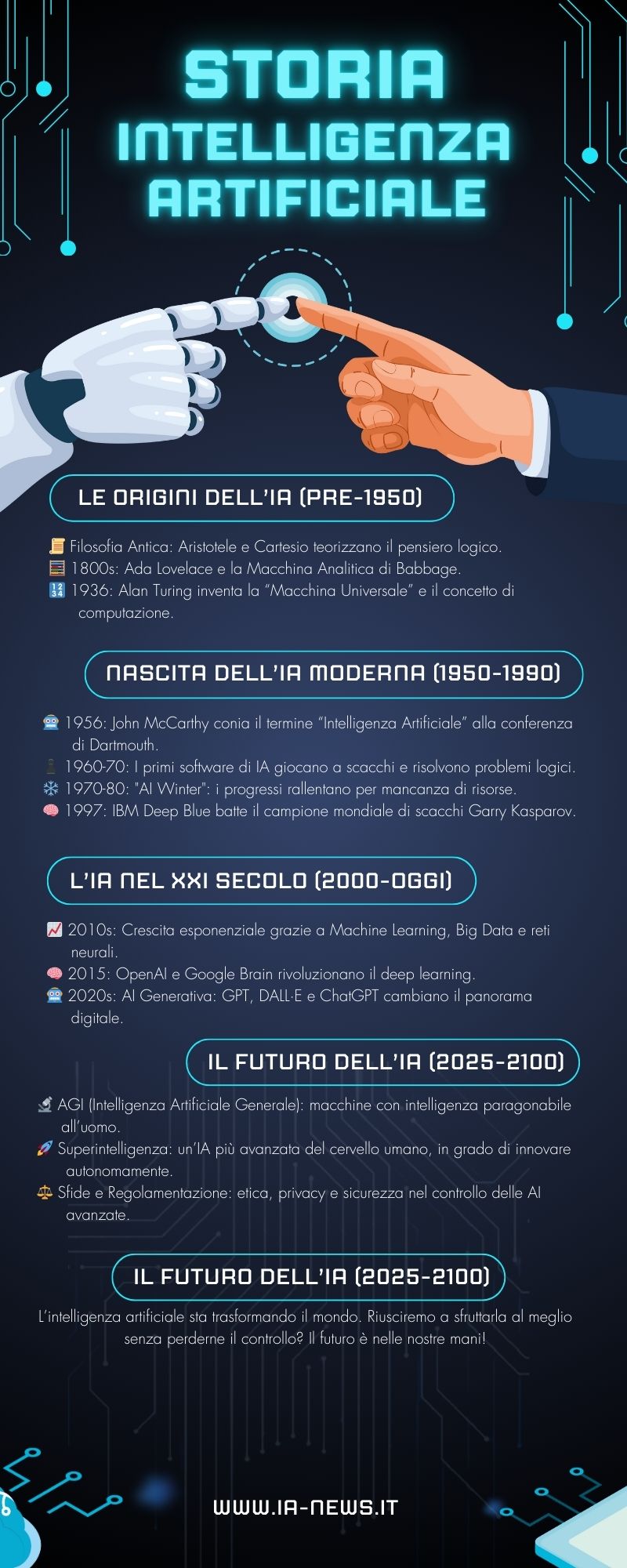

Le Origini dell’Intelligenza Artificiale

La storia dell’intelligenza artificiale ha radici profonde che risalgono a secoli fa, quando filosofi e scienziati iniziarono a immaginare macchine capaci di pensare come un essere umano. Tuttavia, è solo nel XX secolo che il concetto di IA ha iniziato a prendere forma concreta, grazie ai progressi della matematica, della logica e dell’informatica.

L’idea di macchine pensanti nella filosofia antica

L’idea che le macchine possano imitare il pensiero umano non è nuova. Già nell’antica Grecia, filosofi come Aristotele teorizzavano sistemi logici che avrebbero potuto servire da base per macchine intelligenti. Tuttavia, il primo vero tentativo di formalizzare un pensiero automatico risale a Cartesio, nel XVII secolo, con la sua teoria sulla mente e il corpo separati.

Nel XVIII secolo, il matematico e filosofo Gottfried Wilhelm Leibniz sviluppò il concetto di un calcolatore logico in grado di elaborare informazioni seguendo regole matematiche. Questo concetto, seppur rudimentale, anticipava i moderni algoritmi utilizzati nell’intelligenza artificiale.

L’inizio dell’automazione e della logica formale

L’Ottocento fu un periodo cruciale per la nascita dell’intelligenza artificiale. Charles Babbage progettò la sua Macchina Analitica, considerata il primo prototipo di computer programmabile, mentre Ada Lovelace intuì il potenziale delle macchine per elaborare non solo numeri, ma anche concetti astratti.

A fine secolo, il matematico George Boole sviluppò l’algebra booleana, un sistema matematico basato su valori di verità (vero/falso) che sarebbe diventato il fondamento della logica computazionale.

Il XX secolo: la nascita dell’Intelligenza Artificiale

La storia dell’intelligenza artificiale entra nel vivo nel XX secolo, con i primi tentativi di creare macchine capaci di apprendere. Nel 1936, il matematico britannico Alan Turing sviluppò il concetto di macchina universale, un modello teorico che dimostrava come un dispositivo potesse risolvere qualsiasi problema computazionale, se programmato correttamente.

Negli anni ‘40 e ‘50, il progresso delle tecnologie informatiche permise la realizzazione dei primi computer elettronici. Nel 1950, Turing propose il famoso Test di Turing, un criterio per determinare se una macchina può mostrare un comportamento intelligente indistinguibile da quello umano.

Storia dell’Intelligenza Artificiale: La conferenza di Dartmouth e la nascita ufficiale dell’IA

Il termine intelligenza artificiale fu coniato nel 1956 dal matematico John McCarthy durante la Conferenza di Dartmouth, considerata il punto di partenza ufficiale della disciplina. Durante l’evento, un gruppo di scienziati, tra cui Marvin Minsky e Allen Newell, discusse le possibilità di costruire macchine in grado di simulare l’intelligenza umana.

Da quel momento, il campo dell’IA iniziò a svilupparsi rapidamente, con la creazione dei primi algoritmi in grado di risolvere problemi matematici e giocare a scacchi. L’idea che i computer potessero apprendere dall’esperienza pose le basi per il futuro del machine learning e del deep learning.

Lo Sviluppo dell’Intelligenza Artificiale dal 1960 al 2000

Dopo la nascita ufficiale dell’intelligenza artificiale negli anni ‘50, le decadi successive furono caratterizzate da un alternarsi di progressi rivoluzionari e momenti di crisi. Dalla creazione dei primi sistemi esperti fino al boom del machine learning, il periodo tra il 1960 e il 2000 segnò la maturazione dell’IA, preparando il terreno per le applicazioni moderne.

Gli anni ‘60 e ‘70: l’era dei sistemi esperti

Gli anni ‘60 e ‘70: l’era dei sistemi esperti

Durante gli anni ‘60 e ‘70, l’intelligenza artificiale conobbe una crescita entusiasmante. I ricercatori iniziarono a sviluppare sistemi esperti, programmi in grado di simulare il ragionamento umano in ambiti specifici.

- Il primo chatbot: Nel 1966, Joseph Weizenbaum creò ELIZA, un programma capace di simulare una conversazione umana.

- Sistemi esperti: Negli anni ‘70, furono sviluppati i primi sistemi basati su regole, come MYCIN, utilizzato in ambito medico per diagnosticare infezioni batteriche.

- Linguaggi di programmazione IA: Lisp e Prolog divennero i linguaggi principali per la ricerca sull’IA.

Nonostante questi progressi, l’IA di questo periodo era ancora limitata dalle capacità di calcolo dei computer dell’epoca, il che portò a un primo rallentamento nello sviluppo della disciplina.

Gli anni ‘80: il boom dei sistemi esperti e la rinascita dell’IA

Dopo un periodo di stallo, negli anni ‘80 l’intelligenza artificiale tornò a guadagnare attenzione, grazie allo sviluppo dei sistemi esperti. Le aziende iniziarono a investire in software intelligenti per automatizzare processi decisionali complessi.

- Sviluppo dei primi sistemi esperti commerciali: aziende come Digital Equipment Corporation e IBM investirono in IA per la risoluzione di problemi industriali.

- Reti neurali artificiali: Nel 1986, Geoffrey Hinton e colleghi riscoprirono e perfezionarono il concetto di apprendimento tramite reti neurali, aprendo la strada al deep learning.

- Boom degli investimenti: I governi e le aziende investirono milioni di dollari nella ricerca sull’intelligenza artificiale, convinti delle sue potenzialità.

Gli anni ‘90: l’AI Winter e la ripresa con il machine learning

Nonostante l’entusiasmo, le aspettative eccessive portarono a una nuova crisi dell’IA negli anni ‘90, conosciuta come AI Winter. Le aziende e i governi iniziarono a ridurre gli investimenti, a causa delle difficoltà nel realizzare sistemi realmente intelligenti.

Tuttavia, mentre i sistemi esperti perdevano rilevanza, una nuova rivoluzione stava emergendo: il machine learning.

- 1997: La vittoria di Deep Blue su Kasparov: Il supercomputer di IBM sconfisse il campione del mondo di scacchi Garry Kasparov, dimostrando la potenza dell’intelligenza artificiale nell’elaborazione strategica.

- Sviluppo di algoritmi di apprendimento automatico: I ricercatori iniziarono a sviluppare modelli basati su dati reali, gettando le basi per il futuro del deep learning.

Alla fine degli anni ‘90, l’IA era pronta per una nuova fase di crescita, supportata dall’aumento della potenza di calcolo e dalla diffusione di Internet.

Storia dell’Intelligenza Artificiale dal 2000 ad Oggi

Negli ultimi due decenni, l’intelligenza artificiale ha subito una crescita esponenziale grazie all’avvento del machine learning, dei Big Data e della potenza di calcolo sempre più avanzata. Oggi, l’IA è parte integrante della nostra vita quotidiana e continua a trasformare settori chiave come la medicina, la finanza, l’industria e l’intrattenimento.

L’era del Machine Learning: l’intelligenza artificiale diventa autonoma

A partire dagli anni 2000, il machine learning ha rivoluzionato il modo in cui i computer elaborano le informazioni. A differenza delle tecniche tradizionali di programmazione, in cui un algoritmo segue regole predefinite, il machine learning permette alle macchine di apprendere dai dati e migliorare autonomamente le proprie prestazioni.

Uno dei fattori chiave che ha favorito questa rivoluzione è stata l’esplosione dei Big Data. Con la digitalizzazione crescente, ogni giorno vengono generati miliardi di gigabyte di dati, provenienti da social media, transazioni online, sensori IoT e molto altro. Questa enorme quantità di informazioni ha reso possibile l’addestramento di modelli predittivi sempre più sofisticati.

Un altro elemento fondamentale è stato lo sviluppo di algoritmi avanzati, capaci di analizzare dati complessi e trovare correlazioni in modo autonomo. Questo ha portato alla nascita di applicazioni sempre più efficaci in ambiti come il riconoscimento delle immagini, la traduzione automatica e la previsione delle tendenze di mercato.

Storia dell’Intelligenza Artificiale: Google Brain, OpenAI e le nuove frontiere dell’IA

A partire dal 2010, giganti tecnologici come Google, Microsoft e Facebook hanno investito massicciamente nello sviluppo dell’intelligenza artificiale. Nel 2011, Google ha lanciato il progetto Google Brain, che ha contribuito a migliorare la ricerca online e il riconoscimento vocale.

Parallelamente, OpenAI – fondata nel 2015 – ha sviluppato modelli di intelligenza artificiale sempre più potenti, tra cui GPT-3 e successivamente GPT-4, capaci di generare testi complessi con una qualità sorprendente. Questi progressi hanno cambiato radicalmente il panorama dell’intelligenza artificiale, rendendo le macchine non solo più precise, ma anche più “creative” nella generazione di contenuti.

Deep Learning e reti neurali: la rivoluzione dell’IA moderna

Il vero salto di qualità è avvenuto con il deep learning, un sottoinsieme del machine learning basato sulle reti neurali artificiali. Ispirate al funzionamento del cervello umano, queste reti sono in grado di apprendere da grandi quantità di dati e riconoscere schemi con un livello di accuratezza mai visto prima.

Le reti neurali profonde (deep neural networks) hanno trovato applicazione in molteplici settori:

- Computer vision: il riconoscimento facciale e la classificazione delle immagini hanno raggiunto livelli di precisione straordinari.

- Elaborazione del linguaggio naturale (NLP): modelli come GPT-4, DALL·E e ChatGPT hanno trasformato il modo in cui le macchine comprendono e generano testi.

- Automazione industriale: le reti neurali vengono utilizzate per ottimizzare i processi produttivi, migliorare la manutenzione predittiva e ridurre gli errori.

Uno degli esempi più eclatanti dell’impatto del deep learning è stato lo sviluppo di AlphaGo, l’IA creata da DeepMind (di proprietà di Google), capace di sconfiggere i migliori giocatori umani nel gioco del Go, considerato per anni un dominio esclusivo dell’intelligenza umana.

L’IA nella vita quotidiana: tra assistenti virtuali e auto autonome

Oggi, l’intelligenza artificiale è ovunque. Molti strumenti che utilizziamo quotidianamente si basano su tecnologie IA per migliorare l’esperienza utente e automatizzare compiti ripetitivi.

- Assistenti virtuali: Siri, Alexa e Google Assistant sfruttano l’IA per rispondere alle domande, gestire le attività quotidiane e interagire con gli utenti in modo naturale.

- Veicoli autonomi: aziende come Tesla e Waymo stanno sviluppando auto a guida autonoma che utilizzano algoritmi avanzati per analizzare l’ambiente circostante e prendere decisioni in tempo reale.

- Automazione nei settori industriali: le fabbriche stanno adottando robot intelligenti che migliorano l’efficienza produttiva e riducono gli sprechi.

- Medicina personalizzata: l’IA viene utilizzata per diagnosticare malattie, suggerire trattamenti e accelerare la ricerca farmaceutica.

Etica e rischi dell’IA: le sfide di un mondo sempre più automatizzato

Nonostante i numerosi vantaggi, l’intelligenza artificiale porta con sé una serie di questioni che riguardano l’etica e l’intelligenza artificiale e i rischi che devono essere affrontati.

Bias algoritmico e discriminazione

Uno dei problemi principali è il bias nei modelli di IA. Poiché gli algoritmi vengono addestrati su dati storici, possono ereditare pregiudizi già presenti nella società. Questo ha portato a casi di discriminazione nei settori della giustizia, del credito e della selezione del personale. Per evitare questi problemi, è essenziale sviluppare modelli più equi e trasparenti.

Disinformazione e manipolazione

Con l’avvento dei deepfake e della generazione automatica di contenuti, cresce il rischio di manipolazione dell’informazione. Video, immagini e testi artificiali possono essere utilizzati per diffondere fake news e influenzare l’opinione pubblica, rendendo più difficile distinguere il vero dal falso.

Impatto sociale ed economico

L’automazione spinta dall’IA potrebbe portare alla perdita di milioni di posti di lavoro in alcuni settori, mentre ne creerà di nuovi in ambiti tecnologici. La sfida sarà garantire una transizione equa, offrendo opportunità di riqualificazione e formazione per i lavoratori a rischio di sostituzione.

Il Futuro dell’Intelligenza Artificiale: Verso l’Intelligenza Artificiale Generale (AGI)

L’evoluzione dell’intelligenza artificiale è solo all’inizio. Mentre oggi utilizziamo principalmente sistemi di IA ristretta, il futuro punta verso la creazione dell’Intelligenza Artificiale Generale (AGI), capace di apprendere e adattarsi in modo autonomo a qualsiasi compito cognitivo, proprio come un essere umano. Ma cosa significa questo per la nostra società e quali scenari possiamo aspettarci nei prossimi decenni?

Dalla Narrow AI all’Intelligenza Artificiale Generale (AGI)

Attualmente, l’IA che utilizziamo è definita Narrow AI (IA ristretta), ovvero sistemi intelligenti specializzati in compiti specifici, come il riconoscimento vocale, la guida autonoma o la diagnosi medica assistita. Questi algoritmi sono estremamente avanzati, ma non possiedono una comprensione generale del mondo e non possono apprendere concetti nuovi al di fuori dei loro ambiti specifici.

L’Intelligenza Artificiale Generale (AGI), invece, rappresenta la prossima frontiera: un’IA in grado di apprendere autonomamente, ragionare in modo flessibile e adattarsi a nuovi problemi proprio come farebbe un essere umano. Per raggiungere questo obiettivo, gli scienziati stanno lavorando su modelli avanzati di apprendimento per rinforzo, reti neurali più sofisticate e algoritmi che simulano il pensiero astratto.

Storia dell’Intelligenza Artificiale: Le sfide nello sviluppo dell’AGI

Sviluppare un’intelligenza artificiale con capacità cognitive generali è un’impresa colossale. Alcuni degli ostacoli principali includono:

- Comprensione contestuale: attualmente, anche le IA più avanzate hanno difficoltà a comprendere il significato profondo del linguaggio umano, specialmente in contesti complessi o sfumati.

- Apprendimento autonomo: mentre gli esseri umani apprendono da poche esperienze, l’IA ha bisogno di enormi quantità di dati per migliorare le proprie prestazioni. L’AGI dovrebbe essere in grado di apprendere come un bambino, con un numero limitato di esempi.

- Autocoscienza e creatività: una vera AGI dovrebbe non solo eseguire compiti, ma comprendere il perché di ciò che fa e generare nuove idee autonomamente.

Dopo l’AGI: la Superintelligenza Artificiale

Se e quando l’AGI sarà realizzata, il passo successivo sarà la Superintelligenza Artificiale, un’IA che supera di gran lunga le capacità intellettive umane in tutti i campi. Alcuni scienziati, come Nick Bostrom, ipotizzano che una superintelligenza potrebbe rapidamente migliorare se stessa in modo esponenziale, portando a un’accelerazione del progresso tecnologico senza precedenti.

Possibili scenari futuri

Gli sviluppi dell’IA nei prossimi decenni potrebbero portare a scenari molto diversi:

- Utopia tecnologica: un’IA avanzata potrebbe risolvere i problemi più complessi dell’umanità, come il cambiamento climatico, le malattie incurabili e la scarsità di risorse, migliorando la qualità della vita a livello globale.

- Coesistenza equilibrata: regolamentazioni etiche e giuridiche potrebbero garantire che l’IA sia sviluppata e utilizzata nel rispetto dell’uomo, evitando rischi di perdita di controllo.

- Scenari distopici: senza un’adeguata supervisione, una superintelligenza potrebbe diventare imprevedibile, sfuggire al controllo umano o essere utilizzata per scopi dannosi.

L’IA e il futuro del lavoro: opportunità e rischi

Uno degli impatti più discussi dell’intelligenza artificiale riguarda il mondo del lavoro. Con l’avanzare della tecnologia, molte professioni subiranno cambiamenti significativi:

- Automazione dei lavori ripetitivi: mestieri basati su attività ripetitive, come la logistica e la produzione industriale, saranno sempre più automatizzati.

- Nuove professioni: l’IA creerà nuovi ruoli, come esperti di etica dell’IA, sviluppatori di modelli avanzati e specialisti nella gestione dei dati.

- Collaborazione uomo-macchina: invece di sostituire completamente il lavoro umano, l’IA potrebbe diventare uno strumento per migliorare la produttività e la creatività.

L’Intelligenza Artificiale tra Passato, Presente e Futuro

L’intelligenza artificiale ha percorso un cammino straordinario, passando dalle teorie filosofiche dell’antichità ai modelli avanzati di deep learning che oggi plasmano la nostra società. Quella che un tempo era solo una visione fantascientifica è diventata una realtà concreta, in continua evoluzione.

Dalle prime intuizioni di Alan Turing fino alle moderne applicazioni di OpenAI e Google Brain, l’IA ha trasformato il nostro modo di vivere, lavorare e interagire con la tecnologia. Le sue applicazioni sono ormai onnipresenti: dagli assistenti virtuali ai veicoli autonomi, dai sistemi di analisi medica all’automazione industriale.

Tuttavia, con il progresso arrivano anche sfide importanti. Il rischio di bias algoritmico, la manipolazione dell’informazione e l’impatto sul mercato del lavoro sono temi cruciali che richiedono una riflessione etica e una regolamentazione adeguata. La domanda non è più se l’IA cambierà il mondo, ma come sceglieremo di gestire questo cambiamento.

Il futuro dell’intelligenza artificiale dipenderà dalle decisioni che prenderemo oggi. Se regolata e utilizzata con saggezza, potrà diventare uno strumento potentissimo per il bene dell’umanità, aiutandoci a risolvere problemi complessi e migliorare la qualità della vita. Se lasciata senza controllo, potrebbe invece amplificare le disuguaglianze e generare nuove minacce.

L’ultima parola spetta a noi. Siamo pronti ad abbracciare il futuro dell’intelligenza artificiale con consapevolezza e responsabilità?